Zhipu AI, firma stojąca za serią modeli GLM, zaprezentowała swoje najnowsze dzieła: GLM-4.5 i GLM-4.5-Air. To modele nowej generacji, które mają ambicję zunifikować kluczowe zdolności AI – zaawansowane rozumowanie, programowanie i możliwości agentowe – w jednym, spójnym systemie. Przyjrzyjmy się, co oferują i jak wypadają na tle rynkowych gigantów.

Czym są GLM-4.5 i GLM-4.5-Air?

Zhipu AI wprowadza dwa modele z nowej serii, które mają zaspokoić rosnące wymagania skomplikowanych aplikacji, zwłaszcza tych opartych na autonomicznych agentach.

- GLM-4.5: Flagowy model z 355 miliardami parametrów (32 miliardy aktywnych w danym momencie).

- GLM-4.5-Air: Lżejsza, ale wciąż potężna wersja ze 106 miliardami parametrów (12 miliardów aktywnych).

Oba modele to hybrydowe systemy rozumowania, które działają w dwóch trybach:

- Tryb “myślący” (thinking mode): Używany do rozwiązywania złożonych problemów, które wymagają analizy i korzystania z narzędzi.

- Tryb “natychmiastowy” (non-thinking mode): Zapewnia błyskawiczne odpowiedzi na prostsze zapytania.

Kluczową ideą stojącą za GLM-4.5 jest przezwyciężenie specjalizacji, która cechuje wiele obecnych modeli. Zamiast tworzyć systemy, które są dobre albo w matematyce, albo w kodowaniu, Zhipu AI dąży do stworzenia uniwersalnego modelu, który doskonale radzi sobie we wszystkich tych dziedzinach. Więcej o podstawach działania takich modeli przeczytasz w naszym artykule co to jest LLM i jak działają duże modele językowe.

Wydajność w Praktyce: Jak GLM-4.5 Wypada na Tle Konkurencji?

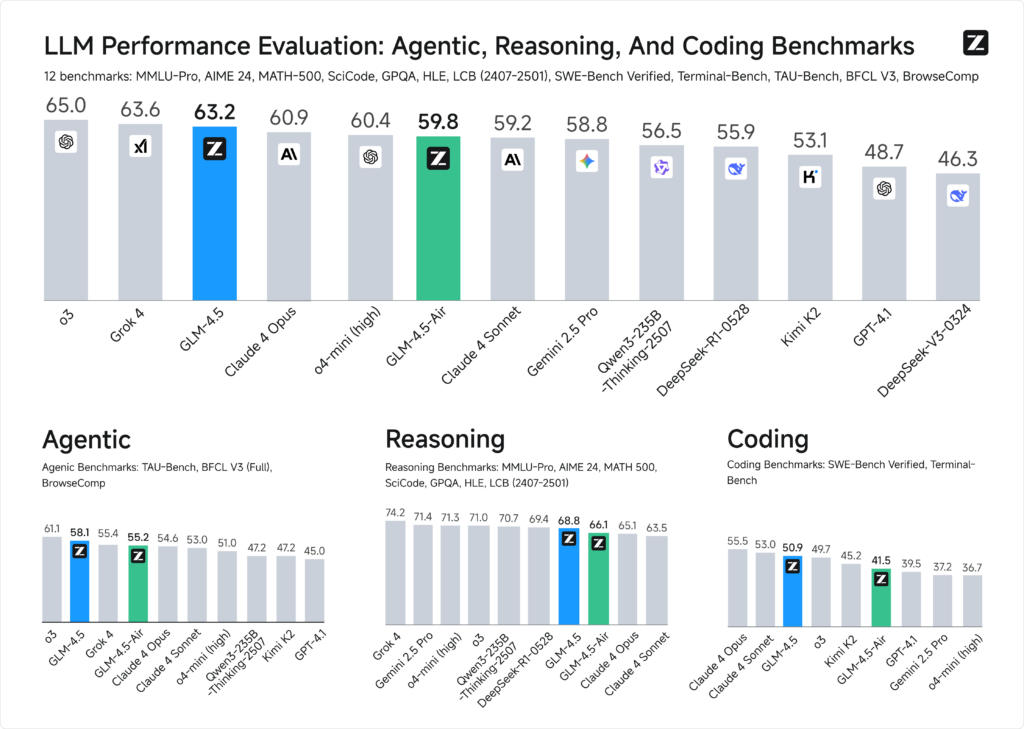

Twórcy przeprowadzili szeroko zakrojone testy, porównując GLM-4.5 z modelami od OpenAI, Google, Anthropic, xAI i innych. W ogólnym rankingu obejmującym 12 różnych benchmarków GLM-4.5 zajął imponujące 3. miejsce, a GLM-4.5-Air 6. miejsce.

Zdolności agentowe: Przeglądanie sieci i korzystanie z narzędzi

Zdolności agentowe to umiejętność modelu do samodzielnego wykonywania złożonych, wieloetapowych zadań. GLM-4.5 został zoptymalizowany w tym kierunku, oferując 128 tys. tokenów kontekstu i natywną obsługę wywoływania funkcji (function calling).

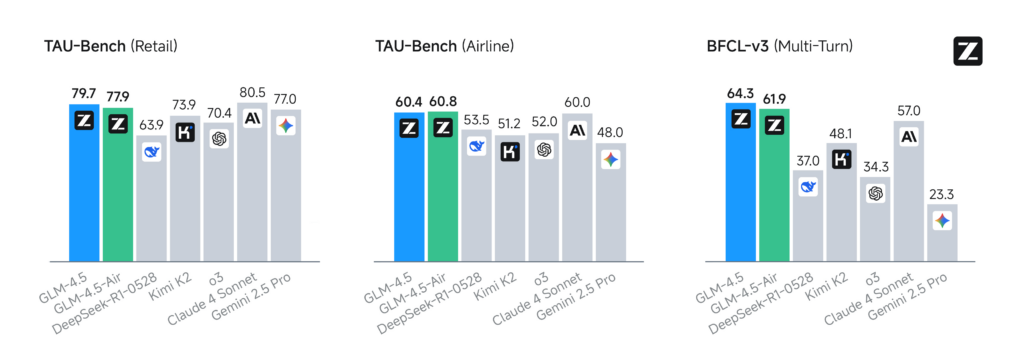

- W benchmarkach tau-bench i BFCL v3, które mierzą zdolność do korzystania z narzędzi, GLM-4.5 dorównuje wydajnością modelowi Claude 3 Sonnet.

- W teście BrowseComp, symulującym przeglądanie internetu w poszukiwaniu odpowiedzi na skomplikowane pytania, GLM-4.5 (26.4% poprawnych odpowiedzi) wyraźnie prześcignął Claude 3 Opus (18.8%), zbliżając się do wyników o4-mini-high (28.3%).

Te wyniki pokazują, że GLM-4.5 może być potężnym silnikiem dla autonomicznych agentów AI, którzy samodzielnie realizują cele postawione przez użytkownika.

Rozumowanie: Matematyka, Nauka i Logika

W trybie “myślącym” GLM-4.5 pokazuje swoją siłę w zadaniach wymagających głębokiej analizy. W testach takich jak MMLU Pro (wiedza ogólna), MATH (problemy matematyczne) czy GPQA (pytania na poziomie absolwenta), model osiąga wyniki plasujące go w ścisłej czołówce, tuż obok takich potęg jak GPT-4, Claude 3 Opus czy Gemini 2.5 Pro. To potwierdza jego użyteczność w zastosowaniach analitycznych i naukowych.

Kodowanie: Od projektów po rozwiązywanie problemów

GLM-4.5 doskonale radzi sobie z zadaniami programistycznymi – od tworzenia projektów od zera po agentowe rozwiązywanie problemów w istniejącym kodzie.

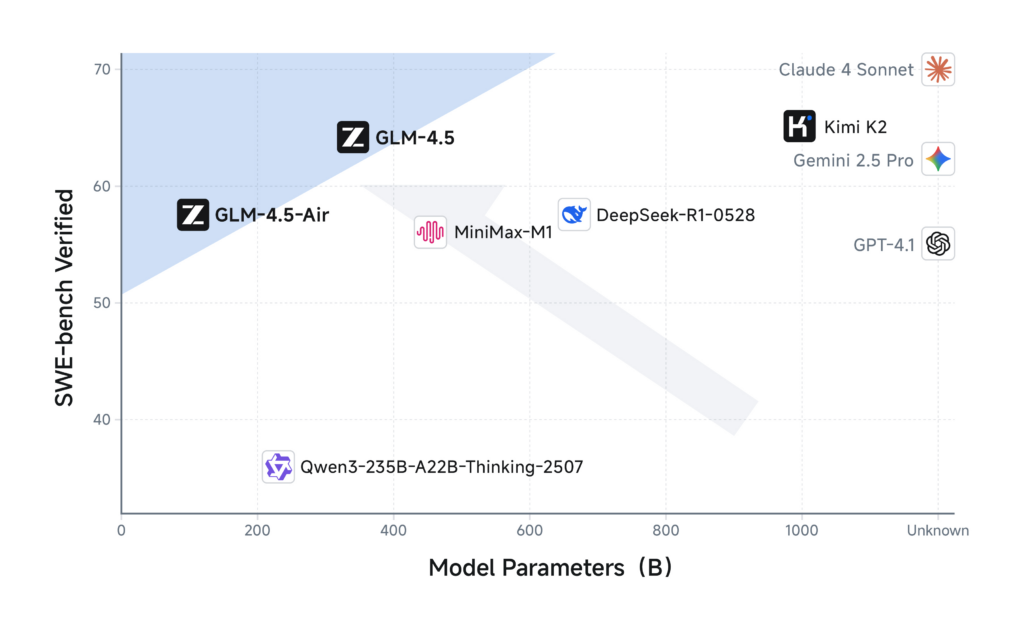

- W teście SWE-bench Verified, który polega na naprawianiu błędów w rzeczywistych repozytoriach na GitHubie, GLM-4.5 (wynik 64.2) pokonuje Claude 3 Sonnet (49.0) i DeepSeek-R1 (41.4).

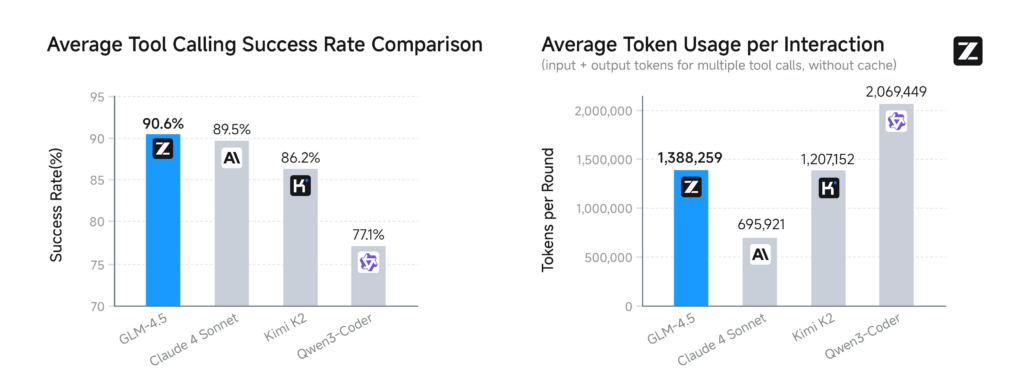

- Co ciekawe, model osiąga najwyższy wskaźnik sukcesu w wywoływaniu narzędzi (90.6%), co czyni go wyjątkowo niezawodnym w zautomatyzowanych zadaniach programistycznych.

Dzięki takim zdolnościom, GLM-4.5 staje się cennym partnerem dla programistów, wspierając ich w codziennej pracy. To kolejny krok w ewolucji narzędzi AI wspierających programowanie.

Praktyczne zastosowania: od gier po aplikacje full-stack

Benchmarki to jedno, ale prawdziwą moc modelu widać w działaniu. Twórcy zaprezentowali kilka imponujących przykładów:

- Generowanie Artefaktów: Model potrafi tworzyć złożone, interaktywne aplikacje, takie jak w pełni grywalna wersja gry “Flappy Bird” w HTML i SVG.

- Tworzenie Prezentacji: Dzięki integracji z narzędziami do wyszukiwania informacji, GLM-4.5 może samodzielnie tworzyć slajdy i plakaty na zadany temat, np. podsumowanie osiągnięć sportowca.

- Full-Stack Development: GLM-4.5 jest w stanie tworzyć kompletne aplikacje internetowe, obejmujące frontend, backend i bazę danych. Jako przykład pokazano stworzenie działającego “Pokédexu” na podstawie kilku prostych poleceń.

Co kryje się pod maską? Architektura i trening

Zaawansowane możliwości GLM-4.5 to wynik przemyślanej architektury i innowacyjnego procesu treningu.

- Architektura MoE (Mixture of Experts): Podobnie jak niektóre inne czołowe modele, GLM-4.5 wykorzystuje architekturę “mieszaniny ekspertów”. Oznacza to, że podczas przetwarzania zapytania aktywowana jest tylko część parametrów modelu, co znacznie zwiększa wydajność obliczeniową.

- Trening na ogromnych zbiorach danych: Model został wstępnie wytrenowany na 15 bilionach tokenów danych ogólnych, a następnie na 7 bilionach tokenów danych skoncentrowanych na kodowaniu i rozumowaniu.

- Uczenie przez wzmocnienie (RL): Zdolności agentowe zostały udoskonalone przy użyciu zaawansowanych technik uczenia przez wzmocnienie. Zhipu AI opracowało w tym celu własną, otwartą infrastrukturę o nazwie

slime, zaprojektowaną do efektywnego treningu modeli w złożonych, wieloetapowych zadaniach.

Zunifikowane AI – Chiński standard

GLM-4.5 i GLM-4.5-Air to coś więcej niż tylko kolejne modele językowe. To dowód na to, że rynek AI staje się coraz bardziej zróżnicowany, a konkurencja napędza innowacje w niespotykanym dotąd tempie. Zhipu AI rzuca rękawicę liderom, oferując model, który nie zmusza do kompromisów między rozumowaniem, kodowaniem a zdolnościami agentowymi.

Dzięki publicznemu udostępnieniu wag modeli na platformach takich jak Hugging Face, społeczność programistów i badaczy zyskuje dostęp do potężnego narzędzia, które może przyspieszyć rozwój nowej generacji inteligentnych aplikacji. Przyszłość AI zapowiada się niezwykle interesująco.