OpenAI dokonało znacznego przełomu w świecie sztucznej inteligencji, wprowadzając model o1, który w opinii wielu specjalistów otwiera nowy rozdział w możliwościach AI. Z technicznego punktu widzenia, trening o1 różni się od tradycyjnych metod, a kluczowe innowacje, które w nim zastosowano, pozwalają na znacznie skuteczniejsze rozwiązywanie złożonych problemów, takich jak zadania matematyczne, kodowanie czy analiza naukowa. W tym artykule przyjrzymy się szczegółowo, jak trenowano o1, aby zrozumieć, co czyni go tak wyjątkowym.

Nowa metodologia treningu o1

Jednym z najbardziej przełomowych elementów treningu o1 jest podejście OpenAI do tworzenia tzw. „łańcuchów myśli” (ang. chain of thought). Tradycyjne modele, takie jak GPT-4, były trenowane na ogromnych ilościach danych z internetu, co pozwalało im naśladując wzorce w danych. Jednak o1 idzie krok dalej. Zamiast jedynie naśladować wzorce, model jest trenowany na generowaniu sekwencji rozumowania. To nowatorskie podejście pozwala modelowi podejmować bardziej złożone decyzje.

Co istotne, OpenAI zrezygnowało z ręcznej anotacji danych, czyli procesu, w którym ludzie krok po kroku oznaczają prawidłowe rozwiązania problemów. Zamiast tego, o1 samodzielnie generuje łańcuchy rozumowania, a następnie te, które prowadzą do poprawnych odpowiedzi, są ponownie wykorzystywane do dalszego treningu. W skrócie, model „uczy się na swoich błędach” i automatycznie dostraja swoje procesy myślowe, aby coraz skuteczniej rozwiązywać zadania.

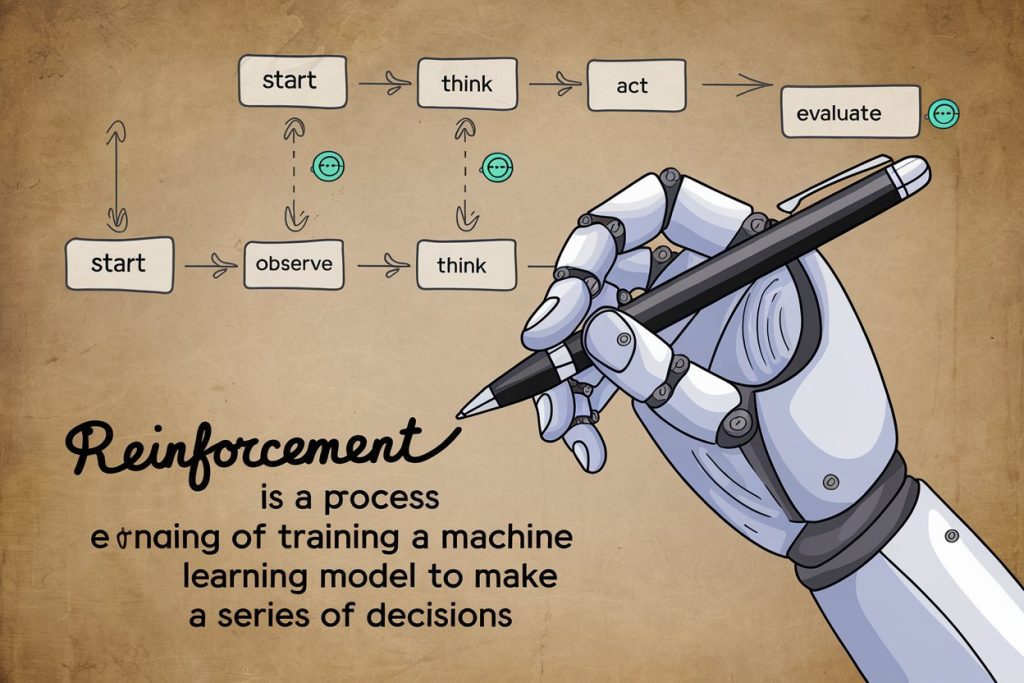

Uczenie przez nagradzanie

O1 jest trenowany za pomocą techniki znanej jako uczenie ze wzmocnieniem (ang. reinforcement learning). Proces ten polega na tym, że model otrzymuje nagrody za poprawne odpowiedzi i kary za błędne. Dzięki temu model doskonali swoje umiejętności, ucząc się, które ścieżki rozumowania prowadzą do najlepszych rezultatów. W przypadku matematyki, fizyki i kodowania, o1 jest w stanie analizować i wybierać najbardziej optymalne rozwiązania, co czyni go znacznie bardziej precyzyjnym niż jego poprzednicy.

Zastosowanie tej techniki znacząco poprawiło efektywność modelu. Tradycyjne modele językowe, takie jak GPT-4, miały tendencję do popełniania błędów logicznych, nawet jeśli naśladowały poprawne wzorce. O1, dzięki „łańcuchom myśli” i uczeniu przez nagrody, jest w stanie analizować i przetwarzać złożone zadania, co pozwala na skuteczniejsze rozwiązania problemów.

Samodzielne generowanie łańcuchów myśli (CoT)

Jednym z najbardziej rewolucyjnych aspektów o1 jest to, że model sam generuje swoje ścieżki rozumowania. Oznacza to, że model nie jest ograniczony przez wcześniej zdefiniowane wzorce, ale potrafi dynamicznie adaptować swoje myślenie do nowych wyzwań. Jednak ważnym elementem tej techniki jest selekcja poprawnych łańcuchów myśli. O1 analizuje swoje wcześniejsze działania i na ich podstawie wybiera te, które prowadzą do najbardziej optymalnych rozwiązań.

Z technicznego punktu widzenia, model nie „rozumuje” jak człowiek w klasycznym sensie. O1 nie rozwiązuje problemów od podstaw, lecz skutecznie „wyciąga” najbardziej odpowiednie sekwencje rozumowania z ogromnych zbiorów danych, na których został wytrenowany. Dzięki temu może efektywnie przetwarzać nawet bardzo złożone zadania, jak testy matematyczne czy skomplikowane zagadnienia fizyczne.

Wydajność i ograniczenia o1

Mimo że o1 przyniósł znaczną poprawę w rozwiązywaniu złożonych problemów, model nie jest wolny od wad. Podczas testów „Simple Bench”, o1 wykazał znaczną zmienność w swoich odpowiedziach. Przykładem może być zadanie, w którym model miał odpowiedzieć na pytanie dotyczące zmiany stanu skupienia lodu. Mimo że w jednym z testów odpowiedź była poprawna, w innym ten sam model udzielił błędnej odpowiedzi. Wynika to z tego, że o1, mimo zaawansowanych umiejętności rozumowania, wciąż jest ograniczony przez swoje dane treningowe.

Model potrafi dokonywać imponujących osiągnięć, jak np. uzyskanie 83% poprawnych odpowiedzi na egzaminach kwalifikacyjnych do Międzynarodowej Olimpiady Matematycznej, co znacznie przewyższa GPT-4, który uzyskał jedynie 13%. Jednakże jego „podłoga” wydajności, czyli najniższy poziom umiejętności, w niektórych przypadkach wciąż pozostaje niższy niż przeciętny poziom człowieka.

Wnioski

Trening modelu o1 oparty na generowaniu i selekcji łańcuchów myśli, w połączeniu z uczeniem ze wzmocnieniem, to nowatorskie podejście, które znacząco zwiększyło zdolności rozwiązywania złożonych problemów. Chociaż model nie jest pozbawiony wad, jego zdolności w zakresie matematyki, fizyki i kodowania przewyższają wcześniejsze modele AI. Jednak, jak wskazują analizy, jego zdolność do rozwiązywania problemów w innych, mniej strukturalnych dziedzinach, jak pisanie kreatywne, wciąż pozostawia wiele do życzenia.

Źródło: AI Explained, OpenAI

3 Comments

Pingback: Nowy model AI DeepSeek-R1 – chiński rywal dla OpenAI o1? - beAIware.pl

Pingback: QwQ-32B-Preview: Nowy model AI od Alibaba

Pingback: OpenAI wprowadza ChatGPT Pro