Na rynku modeli językowych nie brakuje dużych graczy, ale czasem to ci młodsi, dynamiczni zawodnicy potrafią wprowadzić prawdziwe zamieszanie. Tak właśnie wygląda sytuacja z francuskim startupem Mistral, który po raz kolejny udowadnia, że można tworzyć wydajne i przystępne cenowo modele AI. Ich najnowsze dziecko – Mistral Medium 3 – ma być nie tylko szybkie i dokładne, ale też tańsze niż większość konkurencji.

Mocna wydajność bez kompromisów

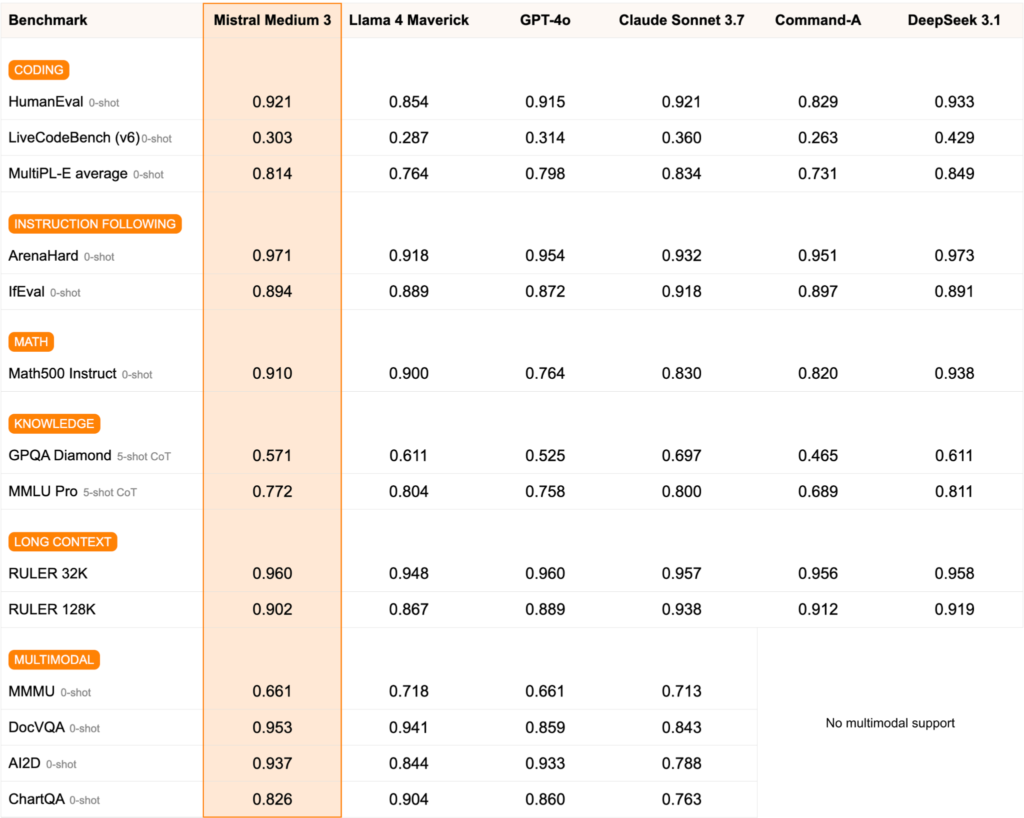

Model Mistral Medium 3 został zaprojektowany z myślą o maksymalnej efektywności – zarówno pod względem działania, jak i kosztów. Według twórców, jego wydajność na benchmarkach plasuje się na poziomie 90% lub więcej w porównaniu z dużo droższym modelem Claude Sonnet 3.7 od Anthropic. Co więcej, Medium 3 bije na głowę inne otwarte modele, takie jak Llama 4 Maverick od Meta czy Command R+ od Cohere.

Ale to nie tylko cyfry robią wrażenie. Model poradzi sobie z przetwarzaniem języka na bardzo wysokim poziomie, a także doskonale odnajduje się w zadaniach związanych z programowaniem, analizą danych i zadaniami STEM. To sprawia, że idealnie nadaje się do zastosowań w sektorach takich jak finanse, energetyka czy opieka zdrowotna – wszędzie tam, gdzie liczy się precyzja i zrozumienie złożonych danych.

Cena, która naprawdę robi różnicę

Mistral Medium 3 dostępny jest w API firmy za 0,40 USD za milion tokenów wejściowych i 2 USD za milion tokenów wyjściowych. Dla porównania, milion tokenów to ok. 750 tys. słów – więcej niż w powieści Wojna i pokój.

W praktyce oznacza to, że model ten może znacząco obniżyć koszty wdrożeń AI w firmach – zarówno tych, które korzystają z rozwiązań w chmurze, jak i tych, które chcą postawić własną infrastrukturę. Wystarczą cztery GPU, aby uruchomić Medium 3 lokalnie, co stawia go w pozycji lidera pod względem opłacalności, nawet w zestawieniu z takimi graczami jak DeepSeek.

Gdzie możesz skorzystać z Mistral Medium 3?

Poza natywnym API, model Mistrala można już uruchamiać na platformie Amazon SageMaker, a wkrótce trafi także na Azure AI Foundry oraz Google Vertex AI. To dobra wiadomość dla firm, które już korzystają z tych ekosystemów – integracja z istniejącą infrastrukturą stanie się jeszcze prostsza.

Co ciekawe, użytkownicy mogą również pracować z Mistralem nad dostosowaniem modelu do własnych potrzeb – np. pod kątem języka specjalistycznego czy unikalnych danych firmowych. To duży plus dla zespołów, które chcą stworzyć AI „szyte na miarę”.

Le Chat Enterprise – chatbot, który mówi ludzkim głosem

Równolegle z premierą Medium 3, Mistral wypuścił również usługę Le Chat Enterprise – inteligentnego chatbota dla firm, który może być zintegrowany z narzędziami takimi jak Gmail, Google Drive czy SharePoint. Co więcej, użytkownicy zyskują możliwość tworzenia własnych „agentów AI” i automatyzowania obsługi klienta czy procesów wewnętrznych.

W najbliższym czasie Le Chat ma otrzymać wsparcie dla MCP – otwartego standardu integracji AI z systemami firmowymi. To kolejny krok ku temu, by AI nie tylko odpowiadało na pytania, ale realnie wspierało zespoły w codziennej pracy.

Mistral rośnie szybko – i nie zwalnia

Startup Mistral, założony w 2023 roku, ma dziś na koncie już ponad 1,1 miliarda euro pozyskanego finansowania i klientów takich jak BNP Paribas, AXA czy Mirakl. To nie tylko potwierdza jego wiarygodność, ale też pokazuje, że rynek wierzy w ich podejście: modele AI, które są jednocześnie wydajne, elastyczne i opłacalne.

Co więcej, już teraz firma zapowiada kolejne premiery – w tym większy model, który ma zostać pokazany w najbliższych tygodniach.

Źródło: TechCrunch

Zdjęcie: Builtin